Big Data und KI bieten auch außerhalb der IT-Branche enorme Potenziale bei der Datenverarbeitung. Das ist längst kein Geheimnis mehr. Allerdings liegen häufig noch veraltete Strukturen hinsichtlich der Strategie-, Projekt-, Maßnahmen- und Aufgabensteuerung vor. Doch wie löst man dieses Problem? Ist es womöglich letztlich alles eine Frage der richtigen Daten?

Nach dem Vorbild des Lean Production Systems von Toyota wurde in den letzten Jahrzehnten eine kontinuierliche Verbesserung des Produktionsprozesses angestrebt. Folgerichtig fragen sich viele Unternehmen, wie sie auch andere interne bzw. externe Unternehmensprozesse schlanker, schneller und kostengünstiger gestalten können. Im Fokus dieser Unternehmensprozesse steht in der Regel, nicht wie beim klassischen Produktionsprozess der Materialfluss, sondern der Austausch von Dokumenten und Informationen.

Im sogenannten „Internet of Everything“ spielen neben Menschen und Dingen („Internet of Things“) insbesondere auch Prozesse (richtige Informationen zum richtigen Zeitpunkt im richtigen Format an die richtigen Adressaten liefern) und Daten (als hilfreiche Unterstützung der Entscheidungsfindung) eine wichtige Rolle. Somit rücken die im Unternehmen verfügbaren Daten in den Mittelpunkt und bilden die elementare Grundlage für die Optimierung von Prozessen (Process Mining) und die erfolgreiche Steuerung eines Unternehmens im Allgemeinen.

Die Auswertung und Optimierung von komplexen, weitreichend vernetzten Daten- und Prozess-Strömen kann ohne Künstliche Intelligenz (KI) kaum mehr bewältigt werden. So ist es unvermeidbar geworden, sich bei der digitalen Transformation auch mit KI auseinanderzusetzen. KI-Technologien ermöglichen das intelligente Erfassen und Aufbereiten von Rohdaten, eine leistungsstarke Mustererkennung sowie die Ableitung von klaren Handlungsempfehlungen.

Die fünf "Vs" von Big Data

Leistungsstarke KI-Systeme und alle darauf basierenden Anwendungen stehen und fallen daher mit der Verfügbarkeit einer umfassenden, qualitativ hochwertigen Datengrundlage.

Hierbei sollten die sogenannten „fünf Vs“ von Big Data Beachtung finden: Volume, Velocity, Variety, Veracity und Value. Diese findet man bspw. in dem Buch „Künstliche Intelligenz verstehen“ von Ralf T. Kreutzer und Marie Sirrenberg nachvollziehbar erklärt.

Mit Volume wird der Umfang der verfügbaren Datenmenge beschrieben. Auf diesen Umfang wirken sich die Breite sowie die Tiefe der verfügbaren Daten aus.

Durch bspw. den zunehmenden Einsatz von Sensoren und die Vernetzung von immer mehr Objekten werden immer umfangreichere Datenströme erzeugt. Laut Statista 2017 verzehnfacht sich das weltweit jährlich produzierte Datenvolumen bis 2025 (auf 175 Zettabyte).

Velocity beschreibt die Geschwindigkeit mit der Datensätze entweder neu erstellt oder bestehende aktualisiert, analysiert und/oder gelöscht werden. Heute können viele Veränderungen in Echtzeit erfasst, dokumentiert und ggf. auch ausgewertet werden.

Unter Variety ist zum einen die Vielzahl der internen und externen Datenquellen zu verstehen, die bspw. im Zuge von KI-Anwendungen – oft zeitgleich – verarbeitet werden müssen. Zum anderen bezeichnet Variety auch die Vielzahl der unterschiedlichen Datenformate (etwa strukturierte, teil- und nicht-strukturierte Textdateien sowie Fotos und Videos), die es auszuwerten gilt.

Mit Veracity ist die Qualität der verfügbaren Daten und Datenquellen gemeint. Im Vergleich zum nachgelagerten Kriterium Value geht es bei Veracity nicht um die Relevanz der Daten, sondern allgemein um den formalen Informationsgehalt. Die Qualität der Daten zielt bei Veracity auf die Dimensionen Korrektheit (Freiheit von Fehlern), Vollständigkeit (Abdeckung aller relevanten Felder), Konsistenz (Freiheit von Widersprüchen) und Aktualität (Gültigkeit der Daten) ab.

Schlussendlich ist mit Value der (Mehr-)Wert bzw. die Verwertbarkeit und damit die Relevanz der Daten im Hinblick auf eine spezifische Anwendung gemeint.

Big Data für Strategie-, Projekt- und Maßnahmenmanagement nutzen

Es ist nicht verwunderlich, dass Global Player wie zum Beispiel Google, Microsoft und Apple den Wert von Daten längst erkannt haben und Vorreiter in Sachen Big Data und KI sind. Doch auch für Unternehmen anderer Größenordnung und außerhalb der IT-Branche bieten die neuen Technologien der Datenverarbeitung enorme Potenziale.

Allerdings liegen hier häufig noch veraltete Strukturen hinsichtlich der Strategie-, Projekt-, Maßnahmen- und Aufgabensteuerung vor. Fortschritte werden in verschiedenen Excel-Listen dokumentiert, Tasks werden via E-Mails versendet und Word-Dokumente existieren in unterschiedlichsten Versionen auf lokalen Rechnern.

Die beste Strategie, um dieses Problem zu adressieren und von den wertvollen Daten innerhalb eines Unternehmens zu profitieren, bietet der Einsatz einer Software in Form eines intelligenten Datenbanksystems.

Bei der Auswahl eines solchen geeigneten Systems gibt es in Ergänzung an die „fünf Vs“ drei zentrale Aspekte zu beachten: die Art der Datenerhebung, die Berücksichtigung von Datenqualität, -integrität & -sicherheit sowie die Umsetzung der Datenverarbeitung & -visualisierung.

Welche relevanten Daten liegen bereits intern vor? Welche können extern beschafft werden? Welche Datenlücke zeichnet sich ab – und wie kann diese geschlossen werden? Wie kann eine kontinuierliche Datengewinnung sichergestellt werden?

- Zentrales Datenbanksystem

- Überall erreichbar (Cloud-basiert)

- Anwenderfreundliche Benutzeroberfläche (intuitiv bedienbar)

Datenqualität (Value): Die in Ihrer Datenbank gespeicherten Daten entsprechen den Standards und Anforderungen des Unternehmens. Dabei wendet das Datenbanksystem eine Reihe von Regeln auf ein bestimmtes oder vollständiges Dataset an und speichert es in der Zieldatenbank.

- Vordefinierte Felder: Feldformat (Zahlenfeld, Textfeld, Benutzerfeld,…..)

- Kategorien mit vorgegebenen Auswahlmöglichkeiten

- Abbildung der gesamten Organisationsstruktur und Querschnittsthemen

Datenintegrität (Veracity): Datenintegrität befasst sich mit der Richtigkeit und Vollständigkeit der in der Datenbank vorhandenen Daten. Sie steuert mithilfe verschiedener Regeln und Prozesse unter anderem, wie Daten eingegeben, gespeichert und weitergegeben werden.

- Pflichtfelder

- Rollen- und Rechtekonzept

- Review-Funktion

- DSGVO-Konformität

Datensicherheit: Während es bei der Datenintegrität darum geht, die Daten über ihre gesamte Lebensdauer hinweg korrekt und nutzbar zu halten, zielt die Datensicherheit darauf ab, Daten gegen Angriffe von außen (sowie auch interne Verstöße) zu schützen. Zur Datensicherheit gehört die Gesamtheit aller Maßnahmen, mit deren Hilfe die Unversehrtheit der Daten gewährleistet wird.

- Password-Policy

- Verschlüsselung der Daten

- Sicheres Speichern und Wiederherstellen

- Updates und Bug-Fixing

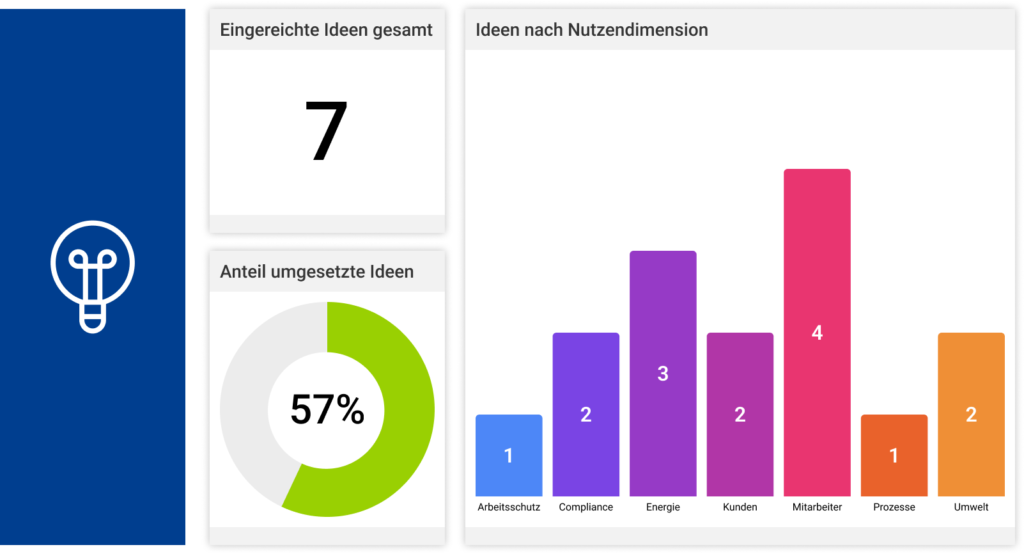

Um einen sichtbaren Mehrwert zu schaffen, müssen die vorliegenden Daten verarbeitet und visualisiert werden. Idealerweise lassen sich sowohl einzelne Aufgaben oder Maßnahmen als auch ganze Projekte oder Strategien punktgenau nachverfolgen und intelligente, individuell konfigurierbare Reports auf Knopfdruck erstellen. Mitarbeiter und Management sind so ständig über den aktuellen Status aller zu erledigenden Maßnahmen und Projekte informiert und haben mittels integrierter Reporting-Funktionen einen schnellen Überblick auf allen Ebenen: Sehen, Verstehen, Handeln, Ziele erreichen.

- Data Cube / OLAP-Würfel

- Dashboard

- Reporting in Echtzeit

- Intelligente Unternehmenssteuerung (KI-Unterstützung)

Intelligente Steuerung von Unternehmensprozessen in Zeiten der Digitalisierung – alles eine Frage der richtigen Daten?

Ja, aber nicht nur. Um eine einfache Datenerhebung, unter Berücksichtigung der Datenqualität, -integrität und -sicherheit ermöglichen zu können, bedarf es Softwareunterstützung in Form eines intelligenten, zentralen Datenbanksystems. Mit Hilfe eines solchen Systems können die Informationen (Data Cube) in allen erdenklichen Dimensionen analysiert und in Echtzeit ausgewertet werden. Dadurch gelingt es Prozesse zu optimieren und zu verschlanken (Process Mining), Transparenz zu schaffen, redundante Datenhaltung zu verhindern und letztendlich die unternehmensinternen Kosten signifikant zu senken. Die Lösungen von MSO übertreffen alle Anforderungen an eine intelligente, softwaregestützte Steuerung von Unternehmensprozessen und greifen dabei auf den neuesten Stand der Technik zurück (Big Data, Data Cube, KI, uvm.).