In Zeiten voranschreitender Digitalisierung besitzen Daten einen immer größeren Anteil am Wertschöpfungsprozess von Produkten und Dienstleistungen bzw. schlicht der Gesamtwirtschaft (Stichwort Industrie 4.0). Eine erfolgreiche digitale Transformation von Organisationsstrukturen, Prozessen und Geschäftsmodellen ist daher essenziell, um erfolgreich zu werden und zu bleiben. Sicher haben Sie auch schon gehört, Daten seien das „neue Öl“ oder andere Vergleiche, mit welchen die herausragende Stellung von Daten im Zeitalter der Digitalisierung hervorgehoben wird. Inwiefern es Sinn ergibt, Daten mit Öl zu vergleichen, wo Gemeinsamkeiten und Unterschiede liegen und was das alles mit aussagekräftigen Reports zu tun hat, erklären wir in diesem Blogbeitrag.

Im vielzitierten Artikel „The world’s most valuable resource is no longer oil, but data“ – erschienen im Economist im Jahr 2017 – wird ein eher negativ behafteter Vergleich zwischen der Ressource Öl und der „neuen“ Ressource Daten gezogen, indem der Autor auf die Monopolstellung der sog. Big Tech Five Google (Alphabet), Amazon, Facebook, Apple und Microsoft (GAFAM) hinweist. Zumeist bezieht sich die Gleichstellung von Öl und Daten als Ressource aber eher auf die Wertigkeit der Daten bzw. das Potential von Big Data mittels künstlicher Intelligenz (KI), Machine Learning (ML) und Data Science.

Exkurs: Die "Geschichte der Daten"

Selbstverständlich fallen Daten bereits seit der dritten industriellen Revolution Anfang der 1970er Jahre und der damit eingeführten Elektronik zur zentralen Steuerung von Produktionsprozessen an. Doch während Daten lange Zeit nur als Ergebnis von Prozessen in den Unternehmen auftraten und unterstützend eingesetzt wurden, sind sie heute gleichzeitig wertvolle Ressource und auch finales Produkt.

Durch den Einsatz von bspw. ERP-Systemen wurden Daten zu einer notwendigen Grundlage für die unternehmerische Wertschöpfung. In der Gesellschaft wird die Nutzung von Informations- und Kommunikationstechnologien (IuK) heute als selbstverständlich angesehen. Durch die ständig wachsende Menge an Daten aus verschiedensten Lebensbereichen können Produkte und Dienstleistungen digital erweitert und miteinander verknüpft werden.

Physische Produkte rücken aktuell im Vergleich zu komplementären Dienstleistungen, Software und Daten mehr und mehr in den Hintergrund. Mit dieser Entwicklung findet auch eine Kehrtwende von der klassischen Produkt- und Servicezentrierung hin zu einer Fokussierung auf maßgeschneiderte Lösungen für individuelle Konsumenten und deren Bedürfnisse. Daten haben sich damit im Lauf der Zeit vom Ergebnis eines Prozesses über Befähiger von Prozessen und Produkten selbst hin zu Produkten entwickelt.

Noch mehr dazu erfahren Sie in dem Whitepaper „Bedeutung von Daten im Zeitalter der Digitalisierung“ des Fraunhofer-Instituts für Materialfluss und Logistik (IML) von 2017.

Interessant an dem Vergleich von Daten und Öl ist auch, dass man ihn ebenso auf den Prozess der Datengewinnung und -nutzung beziehen bzw. weiterspinnen kann. Daten müssen ähnlich wie Öl zunächst (im Unternehmen) ausfindig gemacht, erschlossen und „gefördert“, dann verfeinert und (weiter-) verarbeitet werden. Der Begriff der Data Pipeline wird verwendet, wenn es um das Übermitteln, Konsolidieren und Strukturieren von Daten geht.

Daten als „Ressource der Zukunft“ haben jedoch einen ganz gravierenden Unterschied im Vergleich zu Öl – sie werden nicht verbraucht. Daten sind daher laut dem KI-Forscher Volker Markl in einem Interview mit dem Tagesspiegel von 2020 statt mit einem Rohstoff eher mit einem Produktionsfaktor wie Kapital, Arbeit oder Boden zu vergleichen: „data is not the new oil, but the new soil“.

Aus dem Nährboden Daten können neue Informationen gewonnen werden. Und so wie ein Boden gedüngt oder gegossen werden muss, müssen Daten gepflegt, gereinigt und aktualisiert werden.

Exkurs: Data Supply Chain

In dem Whitepaper „Bedeutung von Daten im Zeitalter der Digitalisierung“ des Fraunhofer-Instituts für Materialfluss und Logistik (IML) von 2017 sind folgende sieben Eckpunkte einer sog. Data Supply Chain (in Anlehnung an eine klassische Lieferkette) festgehalten:

- Beschreibung von Datengütern

Standardisierte Beschreibung der Metadaten und Entwicklung einer Taxonomie - Erkundung von Datengütern

Stichwort Big Data: Auffindbar machen von Daten - Inventarisieren von Datengütern

Verbindung von einzelnen Datensilos und Verfügbarmachen zur Nutzung sowie Pflege und Verwaltung von Datengütern - Bewerten von Datengütern

Definieren von Indikatoren und Methoden zur Messbarkeit sowie Bewertung ökonomischer Werte, technischer Anbindbarkeit und Qualität der Daten - Bereitstellung von Datengütern

Integrierung in Wertschöpfungsketten der Anwender und Anbindung von Datengütern vereinfachen und Bereitstellung eines Frameworks - Konfiguration von Wertschöpfungsketten für Datengüter

Digitale Services aus Geschäftssicht definieren und automatisiert über eine effiziente Anbindung der Infrastrukturen bereitstellen - Synthese von Datengütern

Bedarfsgerechte Aufbereitung der Daten und Prozesse für jeden Anwendungsfall

Schnell wird klar, dass ohne umfassende Datengrundlagen – gekennzeichnet durch die Begriffe Volume, Velocity, Variety, Veracity und Value – keine leistungsstarken (KI-) Systeme funktionieren können. Die fünf V von Big Data finden Sie auch noch einmal in unserem Blogbeitrag „Intelligente Steuerung von Unternehmensprozessen in Zeiten der Digitalisierung“ von 2020 erklärt.

Mit der Qualität des Handlings der fünf V steht und fällt die Qualität aller darauf basierenden Anwendungen. Oft liegen in Unternehmen trotz Digitalisierung noch veraltete Strukturen hinsichtlich der Strategie-, Projekt-, Maßnahmen- und Aufgabensteuerung vor. Fortschritte werden in verschiedenen Excel-Tabellen dokumentiert, Tasks werden via E-Mails versendet und Word-Dokumente existieren in unterschiedlichsten Versionen auf lokalen Rechnern.

Die beste Strategie, um von all den wertvollen Daten innerhalb eines Unternehmens zu profitieren, bietet der Einsatz einer Software in Form eines intelligenten Datenbanksystems. Damit wird die dezentrale Datenbeschreibung in Wikis, Excel-Listen und dergleichen abgelöst. Bei der Auswahl eines solchen geeigneten Systems gibt es in Ergänzung an die fünf V drei zentrale Aspekte zu beachten: die Art der Datenerhebung, die Berücksichtigung von Datenqualität, -integrität & -sicherheit sowie die Umsetzung der Datenverarbeitung & -visualisierung. Auch dies haben wir bereits in unserem Blogartikel zur intelligenten Steuerung von Unternehmensprozessen in Zeiten der Digitalisierung herausgearbeitet, möchten die zentralen Punkte aber in nachfolgendem Exkurs noch einmal zur Verfügung stellen.

Exkurs: Anforderung an die Daten

DATENERHEBUNG

Welche relevanten Daten liegen bereits intern vor? Welche können extern beschafft werden? Welche Datenlücke zeichnet sich ab – und wie kann diese geschlossen werden? Wie kann eine kontinuierliche Datengewinnung sichergestellt werden?

- Zentrales Datenbanksystem

- Überall erreichbar (Cloud-basiert)

- Anwenderfreundliche Benutzeroberfläche (intuitiv bedienbar)

DATENQUALITÄT, -INTEGRITÄT & - SICHERHEIT

Datenqualität (Value): Die in Ihrer Datenbank gespeicherten Daten entsprechen den Standards und Anforderungen des Unternehmens. Dabei wendet das Datenbanksystem eine Reihe von Regeln auf ein bestimmtes oder vollständiges Dataset an und speichert es in der Zieldatenbank.

- Vordefinierte Felder: Feldformat (Zahlenfeld, Textfeld, Benutzerfeld,…..)

- Kategorien mit vorgegebenen Auswahlmöglichkeiten

- Abbildung der gesamten Organisationsstruktur und Querschnittsthemen

Datenintegrität (Veracity): Datenintegrität befasst sich mit der Richtigkeit und Vollständigkeit der in der Datenbank vorhandenen Daten. Sie steuert mithilfe verschiedener Regeln und Prozesse unter anderem, wie Daten eingegeben, gespeichert und weitergegeben werden.

- Pflichtfelder

- Rollen- und Rechtekonzept

- Review-Funktion

- DSGVO-Konformität

Datensicherheit: Während es bei der Datenintegrität darum geht, die Daten über ihre gesamte Lebensdauer hinweg korrekt und nutzbar zu halten, zielt die Datensicherheit darauf ab, Daten gegen Angriffe von außen (sowie auch interne Verstöße) zu schützen. Zur Datensicherheit gehört die Gesamtheit aller Maßnahmen, mit deren Hilfe die Unversehrtheit der Daten gewährleistet wird.

- Password-Policy

- Verschlüsselung der Daten

- Sicheres Speichern und Wiederherstellen

- Updates und Bug-Fixing

DATENVERARBEITUNG UND -VISUALISIERUNG

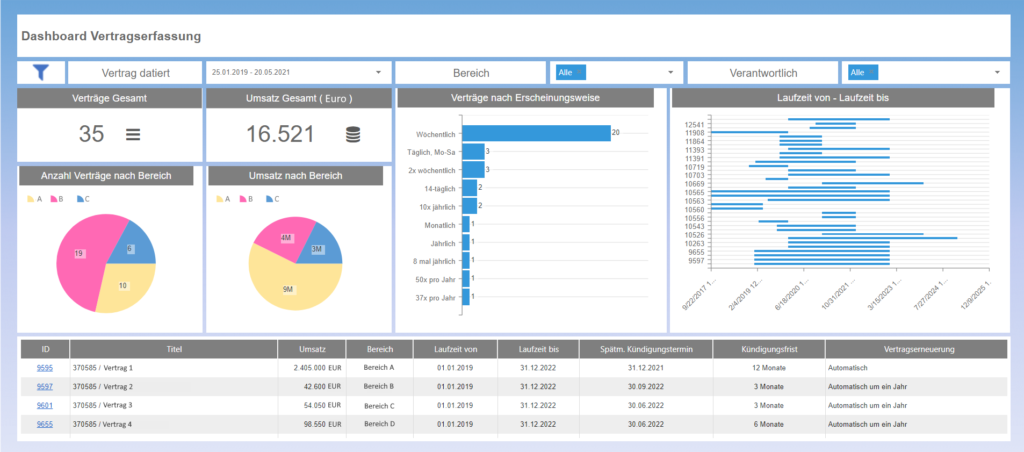

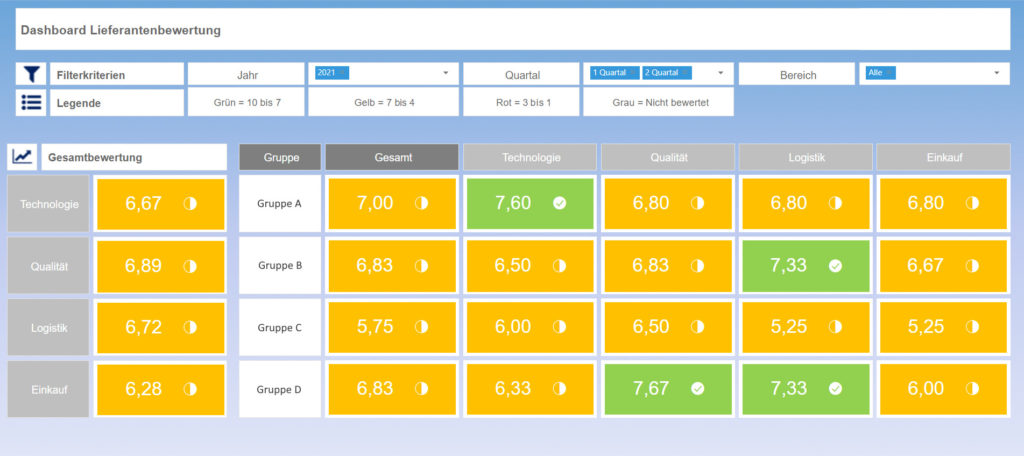

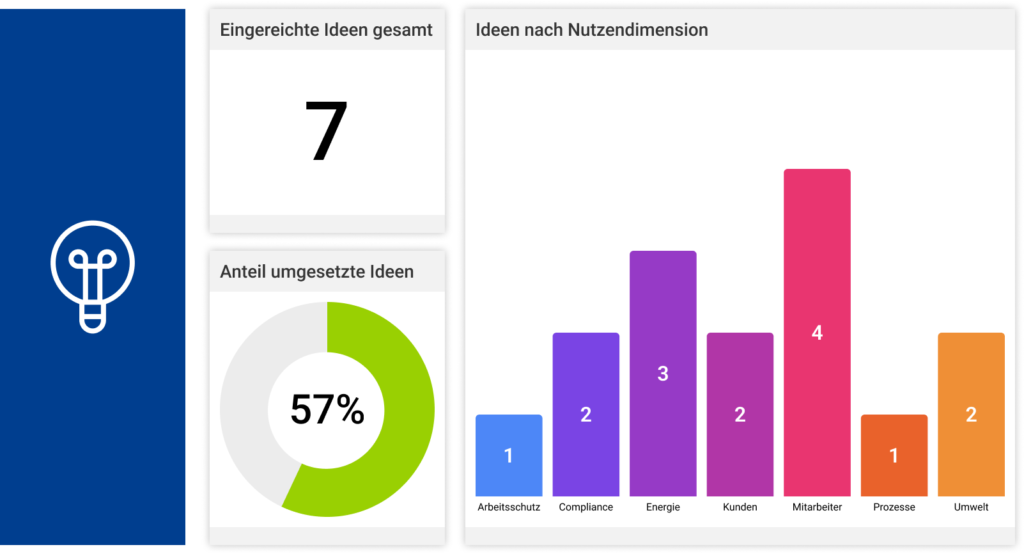

Um einen sichtbaren Mehrwert zu schaffen, müssen die vorliegenden Daten verarbeitet und visualisiert werden. Idealerweise lassen sich sowohl einzelne Aufgaben oder Maßnahmen als auch ganze Projekte oder Strategien punktgenau nachverfolgen und intelligente, individuell konfigurierbare Reports auf Knopfdruck erstellen. Mitarbeiter und Management sind so ständig über den aktuellen Status aller zu erledigenden Maßnahmen und Projekte informiert und haben mittels integrierter Reporting-Funktionen einen schnellen Überblick auf allen Ebenen: Sehen, Verstehen, Handeln, Ziele erreichen.

- Data Cube / OLAP-Würfel

- Dashboard

- Reporting in Echtzeit

- Intelligente Unternehmenssteuerung (KI-Unterstützung)

Im letzten Punkt, der Datenverarbeitung und -visualisierung, heißt es, dass intelligente, individuell konfigurierbare Reports jederzeit auf Knopfdruck erstellt werden können. Ziel ist es heute nicht mehr nur eine deskriptive Analyse (Rückschau) für die Entscheidungsunterstützung zu bieten, sondern vorausschauende Analysen zu ermöglichen, aus denen direkte Handlungsempfehlungen oder automatisierte Reaktionen (Entscheidungsautomatisierung) abgeleitet werden können.

Die Frage ist also nicht mehr nur “Was ist passiert (und warum)?“, sondern vor allem auch „Was WIRD passieren –und was sollen wir tun?“. Auch wer sich sonst als klassischer „Datenmuffel“ bezeichnen würde, erkennt mit Hilfe derartiger, grafisch aufbereiteter Auswertungen plötzlich auf einen Blick den Wert der Daten. Wie dieser Blogartikel zeigt, gelingt ein solches aussagekräftiges Endergebnis mit „Wow-Effekt“ jedoch nur nach gründlicher, andauernder Vorarbeit im Sinne einer umfassenden Datengrundlage und vor allem -pflege.

Für die Transformation in ein digitales Unternehmen, das Entscheidungen auf Basis geeigneter Daten trifft, darf bei Prozessen/Workflows keine Differenz mehr zu beobachten sein zwischen Dokumentation und Realität. Denn das sprichwörtliche „Was ich nicht weiß, macht mich nicht heiß“, kann für Unternehmen schnell gefährlich werden, da nichts verbessert werden kann, was (aufgrund mangelhafter Datengrundlage) nicht gemessen werden kann.

Scheuen Sie deshalb nicht das Eintragen von Daten in eine Management-Software. Ganz im Gegenteil, sehen Sie eine Datenerfassung in einer zentralen Datenbank als Chance, um endlich die Auswertungen zu erhalten, die Sie sich wünschen – und das in Echtzeit auf Knopfdruck in jedem gängigen Dateiformat (.pdf, PowerPoint, Word, …) – immer und überall.

Die MSO Management-Software ist für Ihren Einsatz ohne zusätzlichen Programmieraufwand (No-Code), einfach, schnell, sicher und anwenderfreundlich konzipiert – sodass Sie sich voll und ganz auf Ihre Datenpflege konzentrieren können, um bestmögliche Ergebnisse zu erzielen.

Sie möchten aussagekräftige Reports 1:1 gemäß Ihrer PowerPoint-Folien? Dann kommen Sie einfach auf uns zu!